Evolución de los métodos de investigación UX para Agentes de IA en la colaboración empresarial

\ El cambio ocurrió más rápido de lo que cualquiera predijo. Un día, la IA estaba autocompletando nuestras frases. Al siguiente, se unía a nuestras reuniones, resumiendo nuestras conversaciones y redactando mensajes de seguimiento en nuestro nombre. Ahora está tomando decisiones.

He pasado años investigando cómo los equipos colaboran a través de plataformas inteligentes, y lo que estoy presenciando hoy representa la transformación más significativa en la dinámica del lugar de trabajo desde la introducción del correo electrónico. Los Agentes de IA ya no son herramientas que usamos. Son participantes con los que trabajamos.

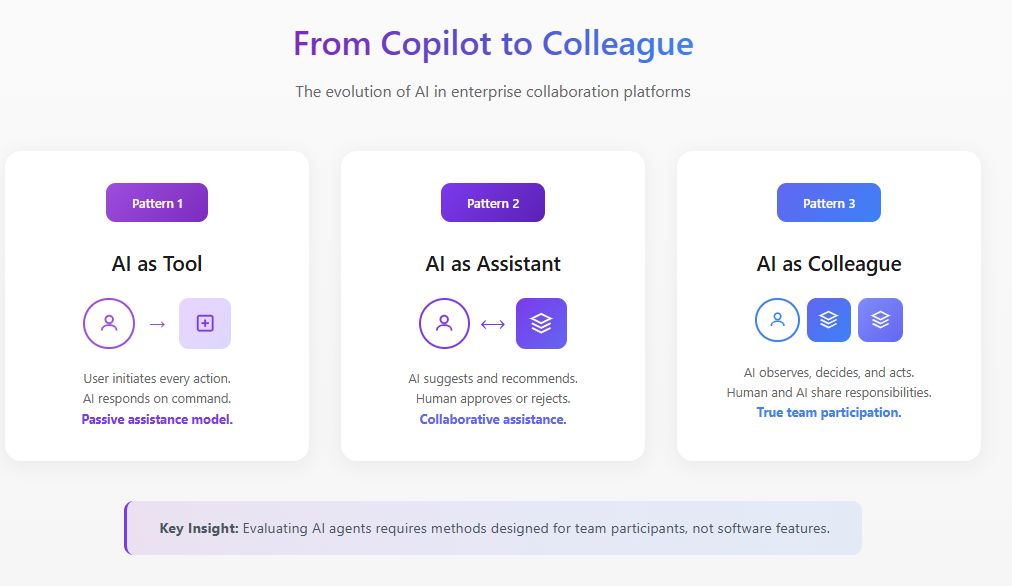

Esta distinción es enormemente importante para los investigadores de UX. Los métodos que desarrollamos para evaluar características de software simplemente no aplican cuando ese software comienza a comportarse como un miembro del equipo.

El Cambio Fundamental: De Característica a Participante

La investigación tradicional de UX hace preguntas como: ¿Es esta característica descubrible? ¿Es intuitiva la interacción? ¿Reduce la fricción en el flujo de trabajo?

Estas preguntas asumen que la IA es pasiva, esperando la entrada del usuario antes de responder. Pero los Agentes de IA operan de manera diferente. Observan, interpretan, deciden y actúan. Según la investigación de 2025 de MIT Sloan Management Review y Boston Consulting Group, el 35% de las organizaciones ya han comenzado a utilizar IA agéntica, con otro 44% planeando adoptarla pronto. Sin embargo, el 47% indica que no tienen una estrategia para lo que van a hacer con la IA. Esta brecha entre adopción y comprensión es precisamente donde la investigación de UX debe intervenir.

Cuando un Agente de IA se une a una plataforma de colaboración, cambia la dinámica social del equipo. Afecta quién habla, cuándo hablan y qué se sienten cómodos diciendo. Evaluar estos cambios requiere métodos que van mucho más allá de las pruebas de usabilidad.

\

Liderando la Evaluación de IA para Plataformas de Colaboración Empresarial

En mi trabajo liderando la investigación de UX para plataformas de colaboración inteligentes, he desarrollado marcos de evaluación específicamente diseñados para Agentes de IA que operan en entornos empresariales. Este trabajo se sitúa en la intersección de la estrategia de producto, el desarrollo de IA y la investigación de factores humanos.

La evaluación de IA en este contexto es fundamentalmente diferente del benchmarking tradicional de modelos. Cuando un Agente de IA opera dentro de una plataforma de colaboración, no podemos simplemente medir la precisión o la calidad de respuesta de forma aislada. Debemos evaluar cómo se desempeña el agente dentro de la compleja dinámica social y operativa de equipos reales.

Abordo las evaluaciones de IA para colaboración empresarial a través de tres capas interconectadas. La primera capa examina el rendimiento funcional: ¿el agente identifica correctamente los elementos de acción, resume las discusiones con precisión y presenta información relevante en los momentos apropiados? La segunda capa evalúa la calidad de integración: ¿cómo opera el agente sin problemas dentro de los flujos de trabajo existentes sin crear fricción o requerir cambios de comportamiento de los usuarios? La tercera capa, y la más frecuentemente pasada por alto, evalúa el impacto sistémico: ¿cómo afecta la presencia del agente a la dinámica del equipo, la calidad de las decisiones y la efectividad colaborativa con el tiempo?

La investigación de Harvard Business Review de mayo de 2025 describe a los Agentes de IA como "compañeros de equipo digitales" que representan una categoría emergente de talento. Este encuadre exige que evaluemos a los Agentes de IA no solo en la finalización de tareas, sino en qué tan bien funcionan como participantes del equipo. Mis protocolos de evaluación incorporan observación del comportamiento, seguimiento longitudinal y análisis de resultados que los benchmarks tradicionales de IA pasan completamente por alto.

Las organizaciones que logran los resultados más sólidos son aquellas que incorporan la investigación de UX directamente en sus ciclos de evaluación de IA, utilizando métricas centradas en el humano junto con medidas de rendimiento técnico.

\

Construyendo Agentes de IA Hiperpersonalizados a Través de Investigación UX Estratégica

La próxima frontera para las plataformas de colaboración empresarial son los Agentes de IA hiperpersonalizados que se adaptan a usuarios individuales, culturas de equipo y contextos organizacionales. Aquí es donde la investigación de UX se vuelve no solo evaluativa sino generativa, moldeando directamente cómo se diseñan e implementan estos agentes.

He estado liderando iniciativas de investigación que informan el desarrollo estratégico de Agentes de IA personalizados para plataformas de colaboración. Este trabajo implica comprender los patrones específicos de cómo diferentes tipos de usuarios interactúan con la IA, cómo varían los estilos de comunicación del equipo entre funciones y geografías, y cómo la cultura organizacional influye en lo que los usuarios esperan de la asistencia de IA.

La investigación de McKinsey de noviembre de 2025 sobre asociaciones de IA señala que realizar el potencial de la IA requiere rediseñar los flujos de trabajo para que personas, agentes y robots trabajen juntos de manera efectiva. Desde una perspectiva de estrategia de producto, esto significa que los Agentes de IA no pueden ser de talla única. Deben adaptar su estilo de comunicación, frecuencia de intervención y nivel de autonomía según las preferencias del usuario y factores contextuales.

Mi investigación ha identificado varias dimensiones de personalización que importan más en contextos de colaboración empresarial. La coincidencia de estilo de comunicación asegura que el agente refleje cómo los usuarios se expresan naturalmente, ya sea formal o casual, detallado o conciso. La calibración del tiempo de intervención aprende cuándo los usuarios individuales prefieren asistencia proactiva versus cuándo quieren trabajar sin interrupciones. El ajuste del umbral de confianza reconoce que diferentes usuarios tienen diferentes niveles de comodidad con la autonomía de IA y calibra en consecuencia.

Las implicaciones estratégicas son significativas. Los equipos de producto que construyen Agentes de IA para plataformas de colaboración necesitan una entrada continua de investigación de UX para comprender cómo funcionan las características de personalización en diversas poblaciones de usuarios. Sin esta base de investigación, los esfuerzos de personalización corren el riesgo de crear agentes que se sientan intrusivos para algunos usuarios mientras parecen inútiles para otros.

Un Marco para Evaluar Agentes de IA en Entornos Colaborativos

A través de una extensa investigación de campo con equipos multifuncionales que adoptan Agentes de IA en sus flujos de trabajo colaborativos, he desarrollado un marco de evaluación construido alrededor de cuatro dimensiones que los métodos tradicionales pasan por alto.

- Impacto de Presencia examina cómo la presencia del Agente de IA cambia el comportamiento del equipo, independientemente de sus contribuciones funcionales. He observado que los equipos se vuelven notablemente más formales cuando saben que una IA está documentando sus conversaciones. Las discusiones laterales disminuyen. El pensamiento exploratorio es reemplazado por contribuciones más seguras.

- Límites de Agencia aborda dónde debe comenzar y terminar la autonomía del Agente de IA, y cómo los equipos negocian estos límites. La guía del Foro Económico Mundial de 2025 sobre Agentes de IA enfatiza que la gobernanza debe promover la transparencia a través del monitoreo continuo. En mi investigación, he encontrado que las preferencias declaradas para la autonomía de IA raramente coinciden con las preferencias reveladas. Los equipos a menudo dicen que quieren que los Agentes de IA tomen más iniciativa, pero se resisten cuando los agentes realmente lo hacen.

- Calibración de Confianza se centra en cómo los equipos desarrollan confianza apropiada, evitando tanto la dependencia excesiva como la subutilización. Un Agente de IA que comete un error significativo puede destruir meses de construcción de confianza, mientras que un agente que se desempeña perfectamente puede crear una peligrosa complacencia.

- Integración Colaborativa examina cómo el Agente de IA afecta la dinámica del equipo, el flujo de información y la inteligencia colectiva. ¿El Agente de IA ayuda al equipo a tomar mejores decisiones, o crea una ilusión de exhaustividad que enmascara un pensamiento superficial?

Caso de Estudio: Reconfigurando el Alcance del Agente de IA

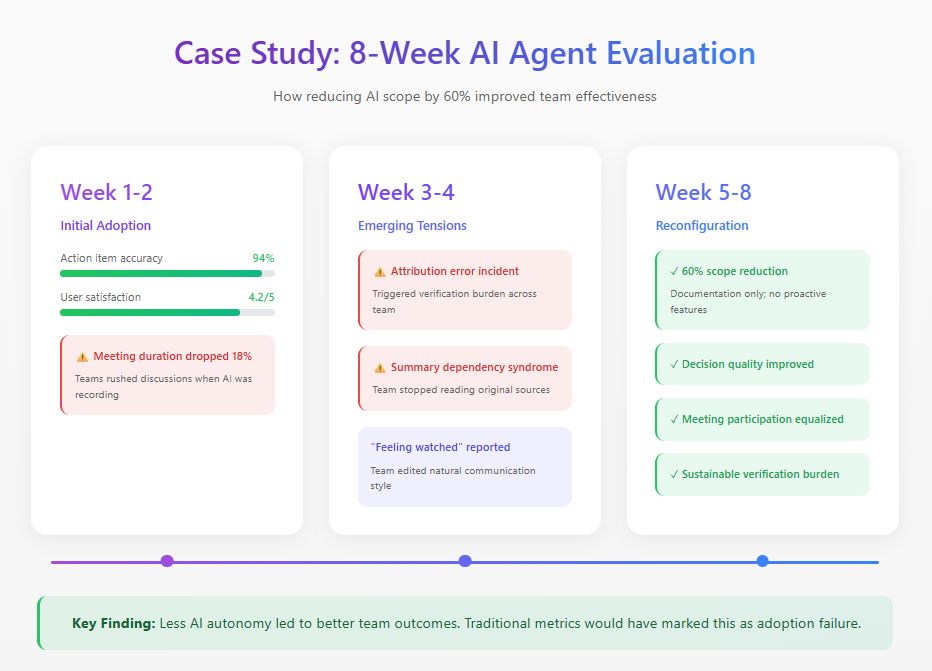

Recientemente realicé un estudio de ocho semanas con un equipo de producto distribuido implementando un Agente de IA en su plataforma de colaboración. El agente fue diseñado para asistir a reuniones, generar resúmenes, rastrear decisiones y presentar proactivamente información relevante.

Las métricas iniciales parecían excelentes: 94% de precisión en elementos de acción, calificaciones de satisfacción de 4.2 de 5. Pero la observación del comportamiento reveló problemas invisibles para los paneles. La duración de las reuniones disminuyó un 18% ya que los miembros del equipo apresuraban las discusiones, conscientes de que cada palabra estaba siendo capturada. Para la tercera semana, un error de atribución desencadenó una carga de verificación que consumió más tiempo que la documentación que reemplazaba. Los miembros del equipo también desarrollaron lo que llamo "síndrome de dependencia de resumen", confiando exclusivamente en los resúmenes de IA y perdiendo contexto crucial.

Basado en estos hallazgos, el equipo reconfiguró el Agente de IA, reduciendo su alcance funcional en un 60%. Eliminaron características proactivas mientras mantenían tareas de documentación donde la precisión era alta. Las métricas tradicionales de adopción marcarían esto como un fracaso. Pero las medidas de efectividad del equipo contaron una historia diferente: la calidad de las decisiones mejoró, la participación en las reuniones se volvió más equitativa, y la carga de verificación se redujo a niveles sostenibles.

El hallazgo más significativo surgió de las entrevistas. Múltiples miembros del equipo describieron sentirse "observados" durante la fase de autonomía completa. Este efecto paralizante en la comunicación auténtica nunca apareció en ninguna métrica de panel.

\

\

Métodos Prácticos de Evaluación

Basado en esta investigación y estudios similares, recomiendo los siguientes métodos para evaluar Agentes de IA en entornos colaborativos.

- Observación Longitudinal requiere períodos mínimos de observación de seis semanas con establecimiento de línea base antes de la introducción del Agente de IA. Las pruebas de usabilidad de sesión única revelan casi nada útil sobre la dinámica colaborativa de IA.

- Análisis de Patrones de Comunicación implica el seguimiento cuantitativo de quién habla, con qué frecuencia y en qué contextos a través de las fases de pre-implementación, implementación temprana e implementación madura.

- Evaluación de Calibración de Confianza mide regularmente cómo la confianza de los miembros del equipo en las capacidades de IA se compara con el rendimiento real de la IA.

- Auditorías de Calidad de Decisiones proporcionan análisis retrospectivo de decisiones tomadas con la participación del Agente de IA, rastreando resultados e identificando dónde la contribución de IA ayudó o dificultó.

El Camino a Seguir

Los Agentes de IA se volverán ubicuos en la colaboración empresarial. La pregunta de investigación no es si las organizaciones los adoptarán, sino cómo los integrarán efectivamente.

Los investigadores de UX tienen un papel crítico en la configuración de esta integración. Poseemos los métodos para entender el comportamiento humano y los marcos para evaluar la calidad de la experiencia. Las organizaciones que lo hagan bien construirán sistemas de colaboración donde humanos y Agentes de IA genuinamente se complementen entre sí. Aquellos que traten a los Agentes de IA como solo otra característica descubrirán que sus equipos trabajan menos efectivamente que antes de que llegara la tecnología.

\

También te puede interesar

Exmagnate de los medios de Hong Kong Jimmy Lai condenado por atentar a seguridad nacional

Polémica en San Luis: productores denuncian ataques a los campos y “delivery de carne robada”

Sheinbaum confirma lo que muchos pensaban de Olinia: no serán autos eléctricos para competirle a Tesla

Claudia Sheinbaum afirmó que Olinia no nace para pelear con autos grandes ni para presumir contra marcas globales. La apuesta, dijo, va hacia e